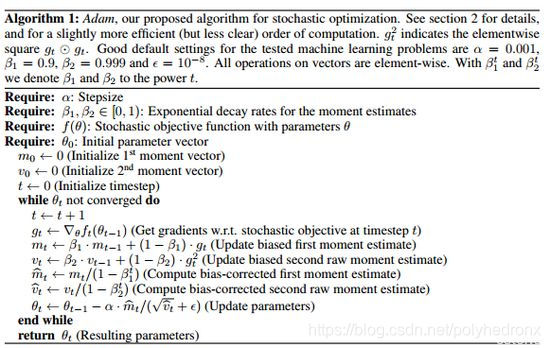

AdamOptimizer是TensorFlow中实现Adam算法的优化器。Adam即Adaptive Moment Estimation(自适应矩估计),是一个寻找全局最优点的优化算法,引入了二次梯度校正。Adam 算法相对于其它种类算法有一定的优越性,是比较常用的算法之一。

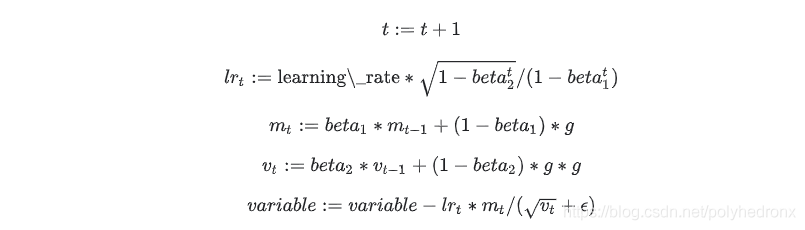

初始化:

更新规则:

参数含义:

下面仅列出一些方法,具体见官方文档(文末参考文献)。

功能:将梯度应用于变量。

功能:计算?var_list 中变量的 loss 的梯度。

功能:返回由 Optimizer 为 var 创建的名为name的slot。

功能:返回由 Optimizer 创建的 slot 名称的列表。

功能:通过更新 var_list 添加操作以最大限度地最小化 loss。

功能:编码Optimizer当前状态的变量列表。

相比于SGD算法:

此外,Adam 的调参相对简单,默认参数就可以处理绝大部分的问题。

?

https://www.tensorflow.org/api_docs/python/tf/train/AdamOptimizer

http://www.tensorfly.cn/tfdoc/api_docs/python/train.html#AdamOptimizer

Copyright © 2012-2021 首页-恒彩平台-注册登录站 备案号:琼ICP备xxxxxxxx号